Alamat Kantor:

Zavira Regeny Blok A7

Batas Kota Pekanbaru - Kampar, Riau — Indonesia

Kita tahu bahwa sebelum melakukan indexing, mesin pencari akan melakukan crawling terlebih dahulu pada setiap halaman website.

Hanya saja, tidak semua halaman website bisa mereka crawling.

Karena ada semacam kode yang mengatur, apakah menghalangi atau mengizinkan crawler untuk merayapi halaman website, kode tersebut disimpan pada file robots.txt

Jadi, robots.txt adalah file yang berisi kode untuk mengatur lalu lintas bot mesin pencari ke halaman website kita, apakah melarang atau mengizinkan.

Menggunakan kode-kode yang kita tempel di file robots.txt kita bisa mengatur apakah website kita boleh di rayapi dan di-index atau tidak.

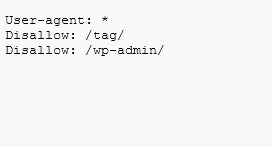

Contoh kode robots.txt standar dari backlinko

User-agent: *

Disallow: /tag/

Disallow: /wp-admin/Cuma kadang tidak semua bot yang mau mengikuti aturan yang kita buat ini. Kita mengenalnya dengan bot buruk.

Mungkin kita akan bahas tentang bot buruk ini pada kesempatan lain.

Sebenarnya robots.txt hanyalah file biasanya yang memiliki extension .txt, kita tidak bisa menyisipkan file html di file ini.

Umumnya, file robots.txt disimpan bersamaan dilokasi file website lain.

Untuk melihat bagaimana konfigurasi file robots.txt website anda, silahkan ketikan alamat website dan kemudian tambahkan dengan tulisan robots.tsxt

Contohnya : www.salman.agency/robots.txt

Biasanya Crawler akan merayapi file ini terlebih dahulu sebelum merayapi halaman lain di website kita. Ini semacam aturan yang harus di ikuti crawler.

Hanya saja, walaupun kita sudah mengatur bagaimana seharusnya bot melakukan perayapan di webiste kita. Ternyata tidak semuanya mau mengikuti.

Maka dari sini kita mengenal bot baik dan buruk.

Ini artinya, file robots.txt tidak benar-benar bisa mengatur bagaimana bot merayapi halaman website kita, karena ia hanya bersifat “himbauan” saja.

Bot yang baik akan mengikuti aturan ini, tapi tidak untuk bot yang buruk.

Maka, bot buruk akan tetap merayapi halaman, file website yang sudah kita larang untuk dirayapi. Karena mereka mengabaikan instruksi dari robots.txt.

Owh ya, sekedar informasi. Setiap instalasi website yang berbeda membutuhkan file robots.txt yang berbeda pula.

Seperti domain utama, subdomain maupun direktori.

Jika kita lihat, sebenarnya perintah “disallow” ini adalah perintah yang paling umum dan sering digunakan dalam file robot txt

Perintah Disallow digunakan untuk melarang crawler mengakses halaman website tertentu yang memang kita kecualikan.

Agar lebih murah dipahami, silahkan lihat contoh penggunakan Disallow

Cara ini digunakan ketika kita ingin memblokir sebanyak satu halaman website saja. Untuk penggunaan kodenya, lihat dibawah ini.

Disallow: /category/seo-website/Url yang dimasukan tidak termasuk nama domain, tapi cukup url website setelah nama domain, seperti yang terlihat pada contoh.

Namun jika anda ingin melarang bot untuk mengakses direktori tertentu, tentu akan lebih efektif langsung memblokir mereka sekaligus.

Bukan satu persatu blokir url pada direktori satu persatu.

Disallow: /__category/Kode diatas akan memblokir semua url yang terdapat pada direktori /__category/ secara keseluruhan tanpa kecuali.

Jika anda tidak ingin memblokir bot apapun untuk mengakses semuah halaman website, tinggal gunakan kode seperti dibawah ini.

Copy dan paste kode dibawah ini ke file robots.txt anda.

Disallow: Terkadang kita ingin memblokir semua bot untuk mengakses website, maka kita bisa menggunakan kode dibawah ini di file robots.txt.

Disallow: /Selain perintah Disallow, Robots txt juga memiliki perintah pengecualian lainnya.

Allow artinya mengizinkan bot untuk merapayapi halaman website tertentu dan mengecualikan halaman website yang lainnya.

Kodenya akan terlihat seperti gambar dbawah ini

Allow: /Untuk saat ini sebenarnya tidak semua website harus memiliki file robots txt, karena bot mesin pencari sudah lebih canggih.

Mereka bisa memilah halaman yang harus mereka index dan mengecualikan halaman yang tidak ingin mereka index.

Halaman dengan konten berkualitas akan mendapatkan tempat disini.

Hanya saja, kadang kita merasa ini masih penting untuk dilakukan. Setidaknya ada 3 alasan kenapa kita butuh file robots txt

Kadang ada halaman tertentu di website kita yang tidak ingin Google mengindexnya. Agar user tidak mengaksesnya melalui Google.

Atau bisa juga karena alasan tertentu.

Jika anda menghadapi situasi ini, maka kita bisa melarang bog untuk merayapi dan kemudian mengindex dengan menggunakan perintah “Disallow”.

Untuk detail tentang perintah ini silahkan cek bagian sebelumnya.

Khusus untuk website besar crawl budget menjadi salah problem umum.

Jika hari ini masih banyak halaman-halaman penting di website yang tidak kunjung di index mesin pencari, mungkin ini soal crawl budget.

Dengan cara memblokir halaman yang tidak penting, maka kita bisa mengoptimalkan crawl budget hanya untuk halaman yang memang ingin kita index saja.

Kadang kita mengupload sumber daya seperti pdf, video maupun slide ke website.

Nah, jika anda tidak ingin mesin pencari mengindexnya dan kemudian menyajikannya ke publik, maka gunakan robots.txt untuk memblokirnya.

Cara memblokir menggunakan robots txt silahkan cek dibagian lain.

Sekarang anda sudah tahu apa itu robots.txt, apa manfaatnya dan bagaimana cara kerjanya. Nah, sekarang kita akan bahas cara menggunakannya.

Untuk anda yang relatif baru di topik ini, bisa ikuti bahasan dibawah ini.

Kita bisa membuat file robots txt ini secara manual di komputer menggunakan notepad dan bisa juga menggunakan plugin.

Khusus untuk pengguna WordPress, kami sarankan gunakan plugin saja.

Plugin yang cukup sering kami gunakan untuk membuat file ini adalah Plugin Yoast SEO, salah satu plugin SEO terbaik saat ini.

Kita cukup masuk pada menu Tools >> File Editor >> Create Robots txt Files

Maka secara otomatis file ini sudah jadi sesuai dengan format standarnya. Jika anda punya pengaturan khusus, silahkan ditambahkan.

Umumnya format dari file ini seperti :

User-agent: X

Disallow: YMisalnya kita ingin memblokir Bot Google untuk mengindek gambar yang terdapat di halaman website yang diterbitkan, maka masukan saja kode seperti dibawah ini.

Dimana GoogleBot adalah User Agen dan image adalah objek yang ingin diblokir. Kode akan terlihat seperti dibawah ini.

User-agent: googlebot

Disallow: /imagesNamun jika anda tidak tahu user agen yang harus diblokir, anda tinggal menggunakan kode seperti dibawah ini di fle robots

User-agent: *

Disallow: /imagesTanda * digunakan untuk menunjukan semua user agen.

Setelah anda membuat file robots txt, jangan lupa untuk menempatnya ditempat yang muda ditemukan oleh bot.

Untuk WordPress umumnya disimpan di file robots txt, apalagi jika anda menggunakan plugin untuk membuatnya.

Ini sudah otomatis tersimpan di file tersebut.

Kita sadar betul bahwa konfigurasi robots txt ini mempengaruhi kinerja SEO website kita secara keseluruhan, sehingga harus diatur dengan baik.

Untuk memastikan pengaturannya sudah valid, maka kita harus tes dulu.

Ada banyak tool pengujian file robots txt diluaran sana, salah satunya adalah Robots Testing Tools dari Google.Silahkan gunakan untuk menvalidasinya.

Robots txt memang bukan kode ajaib yang membuat ranking website anda langsung masuk halaman pertama Google.

Namun, melakukan konfigurasi dengan baik akan membantu website kita agar lebih mudah masuk halaman pertama Google.

Sebaliknya, konfigurasi yang salah bisa menimbulkan masalah.

Ia menjadi bagian dari technical SEO yang harus di audit secara ketat oleh Konsultan SEO yang anda gunakan, jangan sampai di lewatkan.